La guerre automatisée

Temps de lecture : 3 minutes

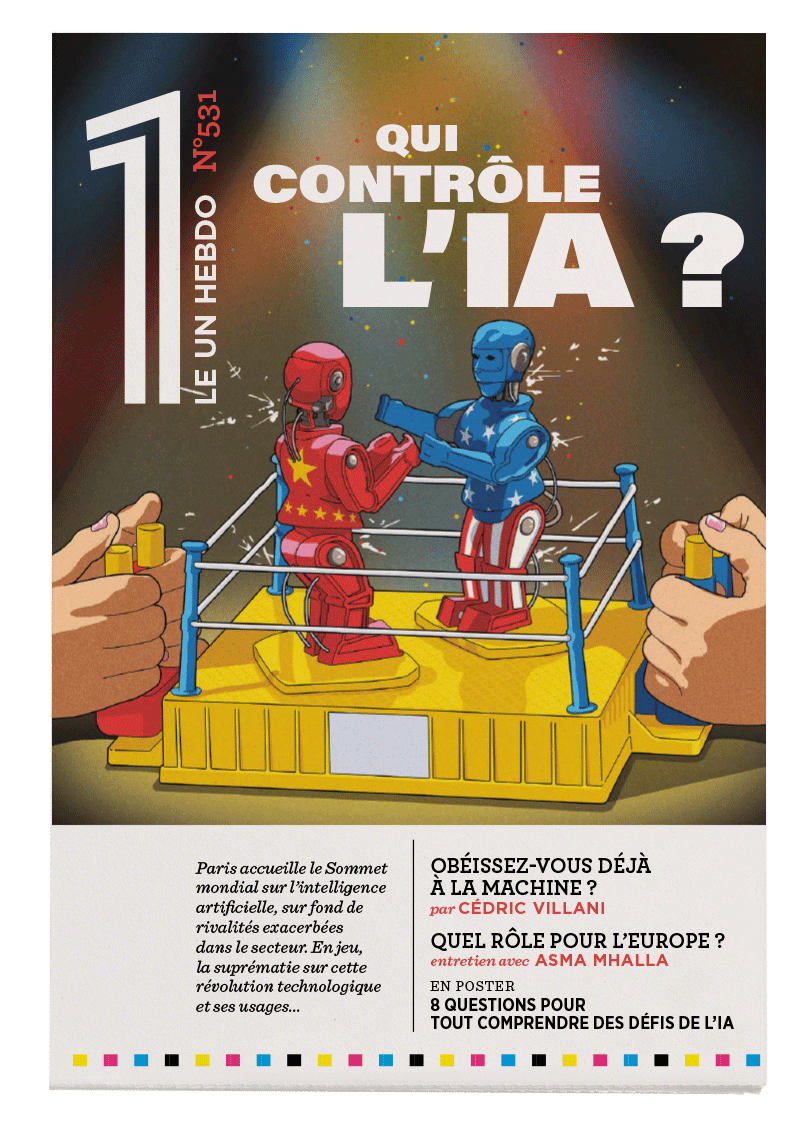

L’IA est désormais au cœur de l’intégralité des forces armées contemporaines. Elle optimise la logistique et la navigation, automatise le ciblage et facilite la collecte de renseignements ainsi que la prise de décision dans les chaînes de commandement. Sur le flanc est de l’Europe, elle permet aux Ukrainiens de compenser leur infériorité numérique face au mastodonte russe grâce à l’intégration en temps réel de solutions technologiques. Au Proche-Orient, Tsahal a utilisé des programmes d’IA avancés pour asseoir sa domination sur le Hamas. L’IA constitue de ce fait un véritable « multiplicateur de force », comparable aux précédentes révolutions des techniques de la guerre, telles que l’invention de la poudre à canon ou de l’arme nucléaire.

Cette automatisation croissante s’accompagne cependant d’une érosion du contrôle exercé sur la force. Les décisions, souvent prises en une fraction de seconde, échappent à la pleine compréhension des opérateurs humains, submergés par un flux massif de données. Ce phénomène, amplifié par l’effet « boîte noire » des algorithmes – dont les processus restent opaques, même pour leurs concepteurs – sape la capacité de discernement humain. Cette opacité est en outre associée au biais d’automatisation, qui décrit une confiance excessive accordée à la machine. Les opérateurs, ne comprenant pas les mécanismes de raisonnement de l’algorithme et supposant que celui-ci repose sur des calculs infiniment plus sophistiqués que les leurs, ont tendance à approuver passivement les choix de la machine, renforçant une dépendance critique à la technologie.

Peut-on laisser des systèmes autonomes prendre des décisions de vie et de mort ?

L’arsenalisation croissante de l’IA pose donc des questions éthiques et juridiques majeures : peut-on laisser des systèmes autonomes prendre des décisions de vie et de mort ? Ces technologies risquent par ailleurs d’abaisser le seuil d’entrée en conflit, compliquent l’attribution des responsabilités en cas de crimes de guerre et pourraient provoquer des escalades incontrôlées. C’est la raison pour laquelle le secrétaire général de l’ONU António Guterres a qualifié les armes autonomes de « politiquement inacceptables et moralement révoltantes ». Pour autant, les efforts multilatéraux visant à réguler l’usage des systèmes d’armes létaux autonomes (Sala) se heurtent à des blocages.

Le cœur du problème réside dans le principe cardinal de contrôle de la force, qui irrigue toutes les autres règles de la guerre. Trois grands corpus sont dédiés à ce principe : l’éthique de la guerre, le droit de la guerre et la stratégie militaire. Or, aucun de ces corpus n’est capable d’embrasser et de maîtriser les technologies émergentes dans le domaine des Sala. Pire, celles-ci remettent en question l’essence même du contrôle de la force.

Ces dérives appellent une régulation urgente et globale

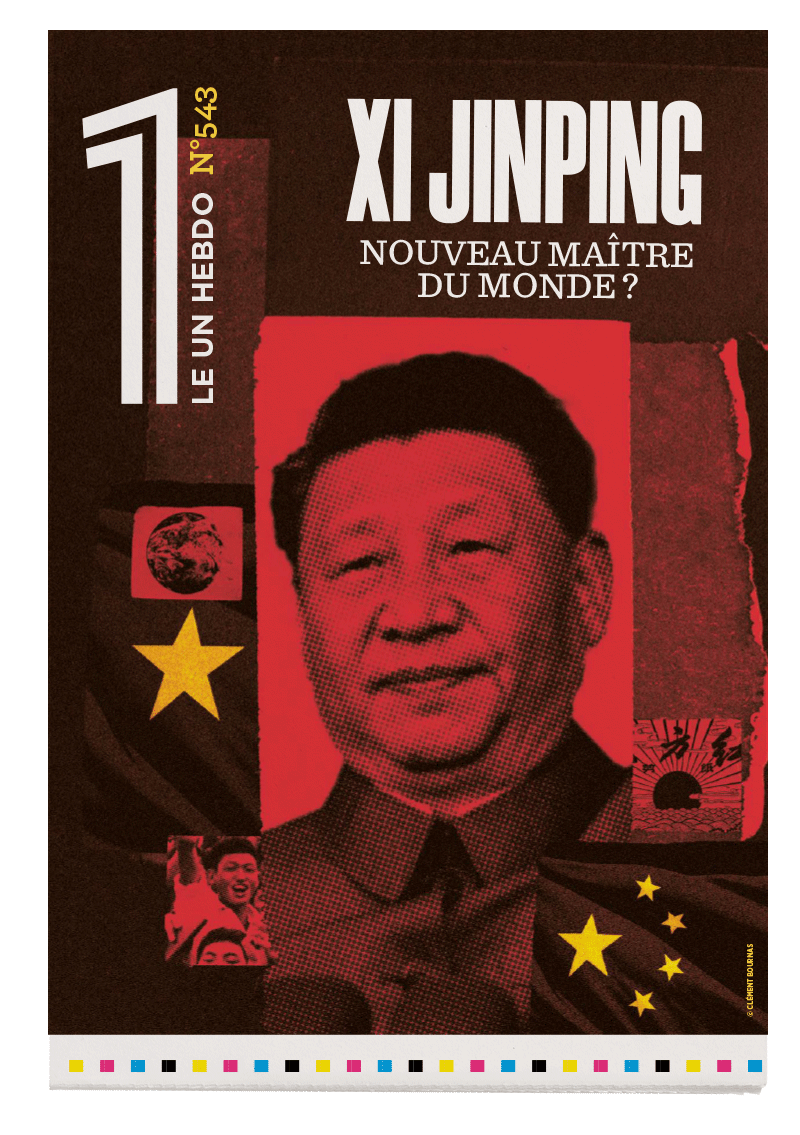

Ce principe se décline en trois dimensions : humaine, politique et internationale. Or, l’IA fragilise chacune d’elles. Le contrôle humain, d’abord, est affaibli par la rapidité et l’opacité des systèmes autonomes. L’autonomisation croissante des systèmes d’armes risque également de rompre le lien entre la volonté politique et l’emploi de la force. Cette dissociation menace la transparence démocratique, rendant l’usage de la force moins visible et plus difficile à encadrer par les citoyens et leurs représentants. L’absence de normes universelles sur les Sala donne enfin lieu à une course aux armements et fragilise les équilibres géopolitiques internationaux. En perturbant la psychologie humaine au cœur des rapports de force, les Sala remettent en question les mécanismes traditionnels de dissuasion et de stabilité stratégique.

Ces dérives appellent une régulation urgente et globale. Encadrer l’IA militaire implique néanmoins d’accepter des contraintes sur l’usage de la force, ce qui est éminemment sensible d’un point de vue politique.

« Les États ne peuvent rien sans la Tech »

Asma Mhalla

La politiste Asma Mhalla dresse un tableau des grands enjeux géopolitiques suscités par l'IA, cette technologie qui a pris une place centrale dans la stratégie de puissance des États.

[Lia]

Robert Solé

JE M’ÉTAIS trompé sur son compte. L’IA (que j’appelle Lia dans l’intimité) n’est pas celle que je croyais...

La guerre automatisée

Laure Roucy-Rochegonde (de)

La politiste Laure De Roucy-Rochegonde revient sur la façon dont l’IA révolutionne le secteur militaire et reconfigure le problème du contrôle de la force en remettant en cause les règles traditionnelles.