8. Peut-on perdre le contrôle de l’IA ?

L’IA en questionsTemps de lecture : 3 minutes

Personnellement, je ne le pense pas. On peut bien sûr rencontrer de graves problèmes avec l’IA si le logiciel est défectueux – comme cela peut arriver lorsque le pilote automatique d’un avion se trompe, même si, dans ce cas, il ne s’agit pas à proprement parler d’intelligence artificielle. Néanmoins, le principal danger encouru avec l’IA réside à mes yeux dans l’usage qu’on en fait. L’an dernier, un avocat américain qui avait utilisé ChatGPT pour préparer un procès a cité de multiples arrêts inexistants. C’est grave, mais l’IA est ici moins en cause que son utilisateur. Reste qu’elle n’est pas un outil anodin : d’usage facile, on l’a mise entre toutes les mains sans que tous soient vraiment au fait de ses capacités et de ses limites. Il faudrait donc former chacun à bien s’en servir.

L’une des craintes les plus répandues est celle d’une IA surclassant l’homme, s’incarnant dans un robot et cherchant à détruire l’humanité. Je n’y crois pas. Il ne faut pas oublier que nous parlons de logiciels ne faisant que ce qui leur est demandé. Il y a une différence entre une intelligence artificielle autonome et une volonté propre. Prenons un robot programmé grâce à de l’intelligence artificielle pour secourir des victimes dans des situations de crise – un accident nucléaire ou l’effondrement d’un immeuble, par exemple. Qu’il soit en partie ou totalement autonome est évidemment nécessaire, sans quoi, en cas de problème de communication entre lui et l’humain, il ne pourrait plus accomplir sa tâche. Mais il n’en changera pas de lui-même : s’il a été programmé pour trouver des victimes sous les décombres, il ne décidera pas tout seul d’aller s’asseoir au bout de la route pour dessiner des fleurs.

Il y a une différence entre une intelligence artificielle autonome et une volonté propre

L’intelligence artificielle pourrait-elle toutefois extrapoler à outrance des réponses à un problème ? Jusqu’où pourrait-elle aller pour réaliser la commande ? Tout dépend de sa programmation et des garde-fous mis en place – en quelque sorte, des « règles » qui lui auront été imposées. Aujourd’hui, avec ce genre de machines, le risque n’est pas qu’elles « violentent » un blessé, mais qu’elles blessent quelqu’un à cause d’un simple écart : souvent lourdes, elles possèdent une grande force ; une petite erreur dans le calcul de leur trajectoire peut les conduire à vous rouler sur le pied ou, pour reprendre l’exemple de la victime sous les décombres, à se déplacer trop vite ou à saisir avec trop de force une personne. C’est pourquoi la robotique nécessite des logiciels vérifiables et certifiables.

Dernière inquiétude : ces outils peuvent-ils être programmés par des gens mal intentionnés ? Oui, bien sûr, comme beaucoup d’autres. Mais cela ne doit pas alimenter le fantasme d’une IA débordant l’intelligence humaine. En réalité, tout dépend ici de ce que l’on entend par « intelligence » : si l’on parle par exemple de la capacité de lire rapidement des pages, les machines nous battent déjà ; pour autant, aucune aujourd’hui ne surpasse l’être humain sur l’ensemble de son spectre intellectuel, dans sa capacité à raisonner et à inventer.

Conversation avec EMMA FLACARD

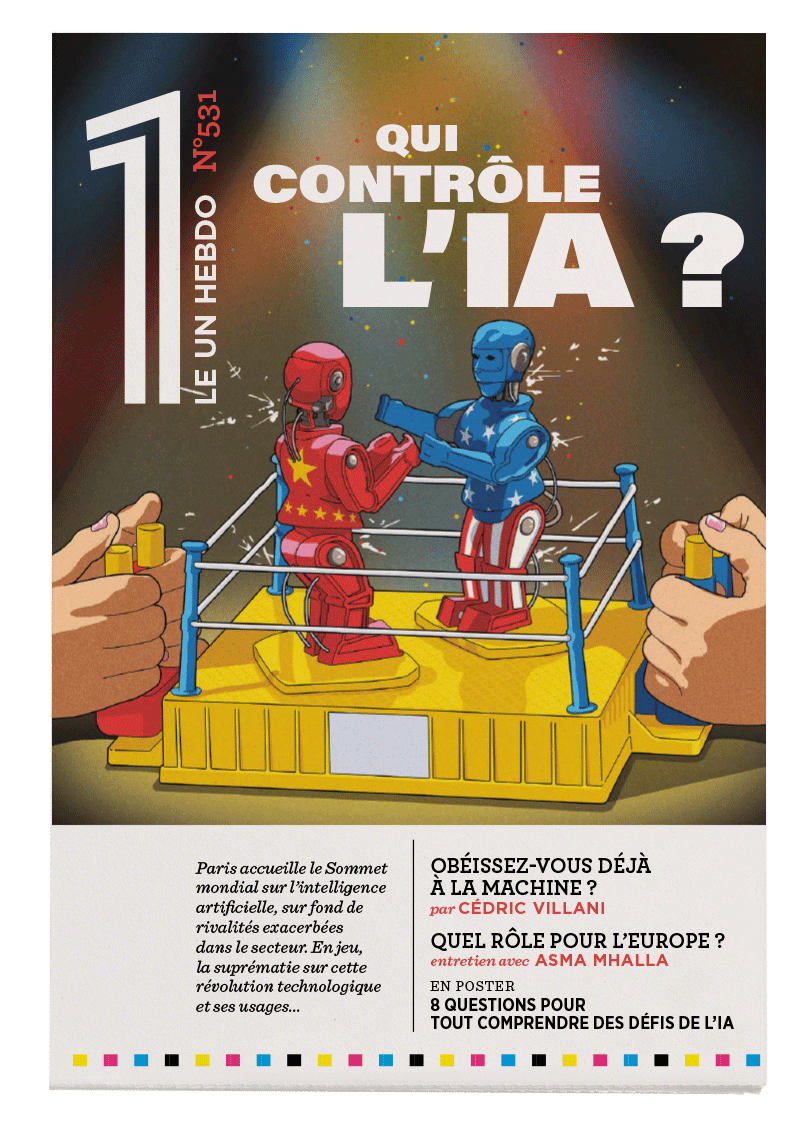

« Les États ne peuvent rien sans la Tech »

Asma Mhalla

La politiste Asma Mhalla dresse un tableau des grands enjeux géopolitiques suscités par l'IA, cette technologie qui a pris une place centrale dans la stratégie de puissance des États.

[Lia]

Robert Solé

JE M’ÉTAIS trompé sur son compte. L’IA (que j’appelle Lia dans l’intimité) n’est pas celle que je croyais...

La guerre automatisée

Laure Roucy-Rochegonde (de)

La politiste Laure De Roucy-Rochegonde revient sur la façon dont l’IA révolutionne le secteur militaire et reconfigure le problème du contrôle de la force en remettant en cause les règles traditionnelles.