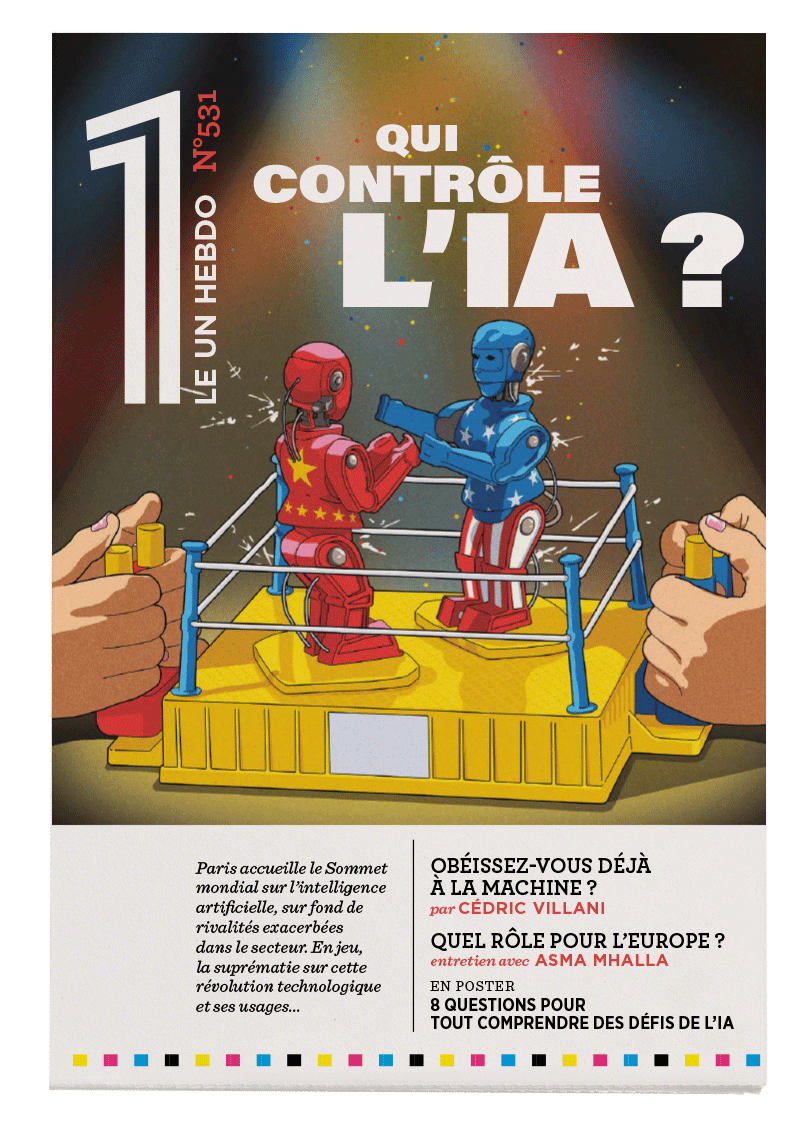

7. Comment contrôler ce que produit l’IA ?

L’IA en questionsTemps de lecture : 3 minutes

Il n’existe pas une seule IA, mais différents systèmes qui utilisent des algorithmes variés. Un logiciel fonctionnant avec du reinforcement learning – ou « apprentissage par renforcement », une méthode qui lui permet de perfectionner ses réponses au fil des expériences auxquelles il est soumis – n’est ainsi pas similaire à une intelligence artificielle générative. Or c’est de ces dernières que l’on parle le plus aujourd’hui. Les IA génératives reposent sur de grands modèles qui suivent différentes phases : la phase d’entraînement et la phase d’inférence. D’abord entraînée sur une grande quantité de données préexistantes, elle apprend ensuite, lors de la phase d’inférence, à en générer de nouvelles, souvent pour répondre à une question précise qui lui est posée par le biais d’une interface de dialogue. Elle peut alors produire la réponse la plus probable.

La vérification est toujours une question très difficile en informatique, même au-delà du champ de l’intelligence artificielle. Dans le cas de l’IA générative, qui sert à produire, et donc à inventer des contenus inédits, que signifierait « vérifier » ? Est-ce par exemple vérifier l’intérêt d’un dessin de presse généré pour illustrer un article et s’assurer qu’il est conforme à nos souhaits ? Est-ce évaluer la véracité d’une information produite ? Dans un cas comme dans l’autre, une évaluation automatique s’avère difficile. Certes, si l’on demande à une IA générative de nous dire en quelle année est né Louis XIV, on s’attend à ce qu’elle nous réponde 1638 et non 200 après Jésus-Christ. Mais, le plus souvent, l’évaluation va reposer sur l’utilisateur, ce qui suppose que celui-ci ait des connaissances suffisamment étendues pour s’apercevoir de fautes éventuelles.

On ne peut pas dire avec une certitude complète si un contenu a été ou non produit grâce à l’IA

On ne peut pas non plus dire avec une certitude complète si un contenu a été ou non produit grâce à l’intelligence artificielle. Pour un texte, on peut supposer qu’il a été produit par une IA en analysant la récurrence de certains mots dans certains contextes, puisqu’une intelligence artificielle produit les mots « les plus probables ». Mais ce ne sont encore que des pistes, et les recherches ne sont pour le moment pas assez concluantes pour être commercialisées. Pour ce qui est des images, il est possible de « tatouer » celles produites par IA grâce à un processus appelé stéganographie : ce sont des marques invisibles à l’œil nu, seulement quelques pixels modifiés ; en utilisant le logiciel adéquat, on retrouve une signature indiquant de manière non falsifiable qui a produit l’image. En développant cette technique, certaines entreprises, comme Google, s’engagent à favoriser la diffusion d’informations justes et compréhensibles pour les êtres humains.

Par-delà le contrôle factuel du contenu généré, comment vérifier si l’IA en question n’a pas été nourrie par d’autres contenus produits par d’autres systèmes d’IA ? Menés par le scientifique Ilia Shumailov, des chercheurs se sont penchés sur la question. Ils ont entraîné un modèle de langue sur des données du Web, puis en ont entraîné un autre sur les données produites par le précédent, puis un troisième sur ces données nouvellement récoltées, et ainsi de suite. Les résultats étaient clairs : au bout de neuf ou dix occurrences, le texte généré par l’IA n’a plus aucun sens. Pourquoi ? Parce que ces modèles proposent des réponses basées sur la probabilité, or l’entonnoir de ce qu’il propose, pour ainsi dire, se réduit. À force de tourner en boucle sur ses propres contenus, l’IA s’appauvrit et se corrompt.

Il reste que le moyen le plus sûr de vérifier ce que produit une intelligence artificielle générative est humain : c’est la vigilance de l’utilisateur.

Conversation avec EMMA FLACARD

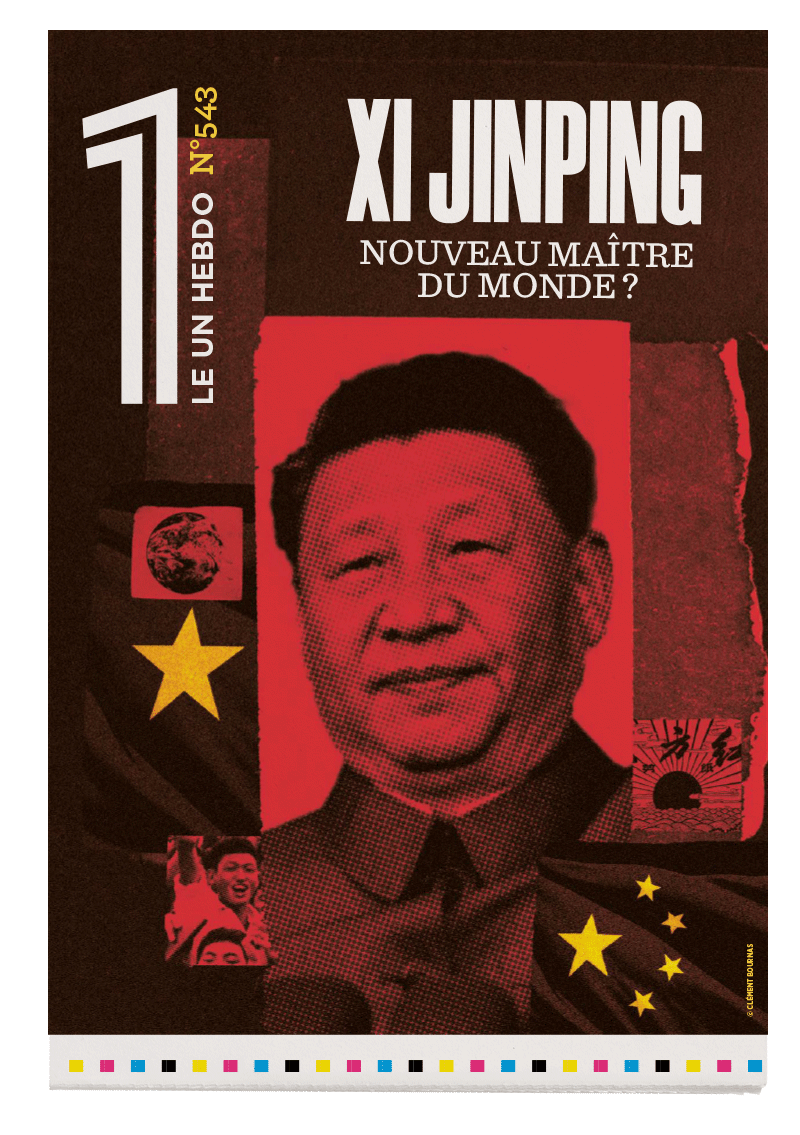

« Les États ne peuvent rien sans la Tech »

Asma Mhalla

La politiste Asma Mhalla dresse un tableau des grands enjeux géopolitiques suscités par l'IA, cette technologie qui a pris une place centrale dans la stratégie de puissance des États.

[Lia]

Robert Solé

JE M’ÉTAIS trompé sur son compte. L’IA (que j’appelle Lia dans l’intimité) n’est pas celle que je croyais...

La guerre automatisée

Laure Roucy-Rochegonde (de)

La politiste Laure De Roucy-Rochegonde revient sur la façon dont l’IA révolutionne le secteur militaire et reconfigure le problème du contrôle de la force en remettant en cause les règles traditionnelles.