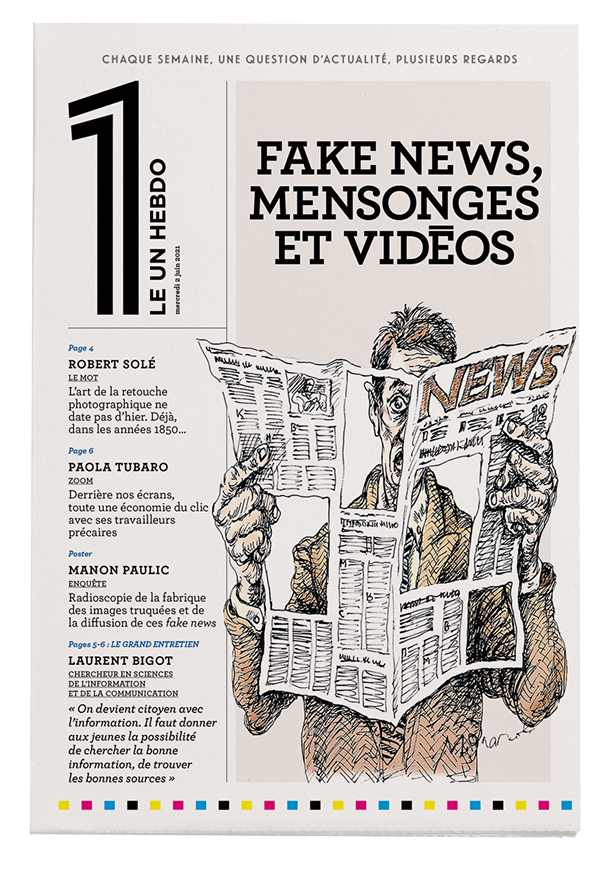

I. La fabrication des fake news

C’est l’une des photographies les plus célèbres de l’histoire. La scène a lieu en Espagne, en 1936, durant la guerre civile. On y voit un républicain, foudroyé en pleine course, s’effondrer dans un mouvement presque théâtral. À sa publication dans le magazine Life l’année suivante, le cliché baptisé « Mort d’un milicien » est accompagné d’une légende : « L’appareil photo de Robert Capa saisit un soldat espagnol au moment où il est abattu par une balle dans la tête en face de Cordoue. » Pourtant, aucune trace de balle sur le crâne du milicien ni la moindre goutte de sang sur sa chemise blanche, finit par remarquer un journaliste américain en 1975. Depuis, d’autres experts ont questionné l’événement, l’arrière-plan de la scène semblant correspondre parfaitement aux collines d’Espejo, un village situé à 35 kilomètres du champ de bataille sur lequel s’affrontent partisans de Franco et républicains. Et si l’une des « 100 photos les plus influentes de tous les temps », selon le magazine Time, n’était qu’une mise en scène ?

Le doute qui continue de planer sur le cliché iconique de Capa nous rappelle qu’une image n’est jamais synonyme de preuve irréfutable. Dès l’apparition de la photographie, au xixe siècle, il a été possible de la manipuler. En la décontextualisant, d’abord – comme ce fut possiblement le cas pour ce cliché – mais aussi en la retouchant. Les exemples ne manquent pas : Mussolini exigeant qu’on gomme le groom qui tenait la bride de son cheval pour gagner en prestance, ou Staline faisant disparaître ses ennemis politiques qui posaient à ses côtés. Les techniques sont alors primaires : crayon à papier, encre de Chine, fusain, peinture, vernis à retoucher souvent appliqués directement sur le négatif. On n’hésite pas à estomper une ride, redresser un nez tordu ou assombrir un ciel trop clair.

Un siècle plus tard, la manipulation des images repose toujours sur ces deux techniques : décontextualisation et retouche. L’évolution des technologies a seulement rendu la pratique plus discrète et accessible à tous, favorisant l’émergence d’un concept : les fake news. Malgré la multitude de logiciels et d’applications facilitant la retouche, « la plupart des images manipulées qui circulent actuellement sont des photos ou des vidéos décontextualisées », constate Denis Teyssou, responsable du Medialab de l’AFP. Son équipe est à l’origine d’un logiciel de détection de fausses images, WeVerify. La fabrication de ces fake news, qui ne demande aucune compétence technique, est à la portée de tout internaute : on récupère une image sur le Web et on la publie de nouveau avec une légende mensongère.

Le Web regorge de ces images, comme la photo partagée en début d’année des centaines de fois en 24 heures d’une dizaine de corps enveloppés de linceuls et étendus dans une cour en terre battue. Les victimes ont été présentées comme celles d’une frappe aérienne de l’armée française survenue le 3 janvier 2021 à Bounti, dans le centre du Mali. Sans préjuger ou non de la réalité de cette attaque, une recherche par similarités – la photo est envoyée sur de multiples moteurs de recherche pour vérifier une éventuelle existence antérieure – permet de découvrir qu’il s’agit d’un cliché datant de 2014 et rendant compte du massacre d’un village au Nigeria par le groupe terroriste Boko Haram.

La décontextualisation est également massivement utilisée pour manipuler des vidéos. Les exemples récents abondent. En 2018, lors d’un séjour en Crète, un touriste tchèque filme une scène qui retient son attention : un groupe de personnes, dont plusieurs femmes voilées, flotte sur la mer tandis qu’une équipe de tournage enregistre la séquence. Le touriste diffuse aussitôt sa vidéo, pensant ou voulant faire croire qu’une équipe de journalistes met en scène des migrants en pleine noyade pour tromper le public. Il était en réalité en train d’assister au tournage d’un documentaire historique sur l’arrivée de réfugiés grecs venus d’Anatolie, fuyant la guerre gréco-turque en 1922. Trop tard, la fake news est diffusée et le mal est fait.

La retouche d’images, bien qu’un peu moins répandue car plus technique, n’est pas en reste. Grâce au développement de filtres dits forensics, il est désormais possible de détecter l’endroit ou une image a été altérée. En mars 2020, la photo d’un groupe de soignants réuni autour d’une pancarte antipolice a été partagée des milliers de fois sur Facebook. Les filtres permettent de constater, grâce à un système de couleurs, qu’une retouche importante a eu lieu au niveau du texte. Sur la photo originale, la pancarte appelait en réalité à ne pas aller voter aux élections municipales afin d’éviter la propagation du virus. Ces images manipulées, elles aussi, circulent sans limite sur la Toile.

La même année, une autre photo a marqué les esprits : celle d’une fillette portant un masque à gaz et tenant un koala dans le creux du bras, devant un brasier. La photo s’est propagée comme une traînée de poudre, devenant le symbole de l’inaction des gouvernements du monde face au dérèglement climatique. Il s’agissait en réalité d’un montage réalisé – de manière tout à fait assumée – par une artiste (@thuie, sur Instagram) à partir d’une photo de sa propre fille. L’artiste souhaitait ainsi rendre hommage aux pompiers australiens.

II. L'impact de l’I.A.

Cet équilibre entre images retouchées et images décontextualisées pourrait s’inverser dans le futur, à mesure que progresse l’intelligence artificielle. « Dans moins de cinq ans, avec le portrait de quelqu’un, on pourra fabriquer n’importe quelle image », prédit Marie Sacksick, data scientist et co-organisatrice de l’événement « Paris Women in Machine Learning & Data Science ». En 2014, le chercheur américain Ian Goodfellow inventait les réseaux antagonistes génératifs, autrement appelés « GANs ». Ces réseaux de neurones artificiels, en s’entraînant l’un contre l’autre, sont capables de fabriquer des images totalement singulières et convaincantes à partir d’une bibliothèque de base. Ils sont à l’origine, entre autres, des applications de face swapping, de morphing, ou encore de la fabrication de portraits ultraréalistes, comme ceux du site thispersondoesnotexist.com, dont aucun des portraits générés ne correspond à une personne réelle. Ils rendent également possible, par exemple, la création d’une photo de paysage imaginaire à partir d’une peinture, ou le remplacement d’un élément par un autre sur une image. Pour l’heure, les GANs ont encore besoin d’un certain nombre d’images de base pour travailler, mais bientôt, la technique sera plus autonome.

Les GANs offrent par ailleurs des possibilités vertigineuses en matière de vidéo : il est désormais possible de faire revenir les morts et de mettre en scène, par exemple, un Mouammar Kadhafi se promenant dans une rue de Paris dans laquelle il n’a jamais mis les pieds, prononçant des mots qu’il n’a jamais prononcés. On parle alors de deepfakes. Pour comprendre les implications potentielles de l’intelligence artificielle dans la création de fausses vidéos, il faut se pencher sur le travail de jeunes start-up comme Lyrebird, à l’origine de la technique du clonage de voix. À partir d’un enregistrement relativement court, leur technologie est capable de synthétiser la voix d’un humain et de lui faire dire à peu près tout et n’importe quoi. Associé aux possibilités qu’offrent d’autres start-up comme Synthesia, spécialisée dans le trucage de mouvement via l’I.A., qu’il s’agisse de mimiques faciales, de mouvements labiaux ou de mouvements du corps dans sa totalité, le clonage de voix ouvre la porte à une nouvelle génération de fake news de plus en plus crédibles.

En 2018, dans une démarche de sensibilisation du public, le réalisateur américain Jordan Peele avait publié la vidéo d’une interview de Barack Obama totalement fabriquée, dans laquelle l’ancien président des États-Unis insultait son successeur, Donald Trump. Le résultat est à s’y méprendre. Il existe encore aujourd’hui des moyens techniques pour détecter si une voix a été générée, mais pour combien de temps ? « Dans deux ou trois ans, je pense que ce ne sera plus possible, l’audio et la vidéo seront devenus trop parfaits », prédit Alexandre de Brébisson, cofondateur de Lyrebird.

À l’heure actuelle, son logiciel de clonage de voix baptisé Descript est notamment utilisé comme un outil d’édition rapide par des créateurs de podcasts ou des journalistes radio anglophones. Le logiciel transcrit automatiquement le fichier audio, il suffit ensuite de corriger directement dans le texte pour que la voix artificielle de l’animateur change le contenu de la bande-son, sans que ce dernier n’ait à se rendre de nouveau en studio. Pratique pour corriger un lapsus ou nettoyer un enregistrement des balbutiements, silences ou tics de langage, cette utilisation pose néanmoins de vraies questions éthiques : potentiellement, le logiciel permet aussi de modifier les réponses d’un invité ou de changer les questions du journaliste. « On a très vite été conscients des possibles dérives », précise Alexandre de Brébisson, qui a tenu à accompagner son invention d’une charte éthique.

Pour l’heure, s’il veut créer cette voix synthétique, l’utilisateur doit commencer par lire un texte spécifique en guise de consentement. La voix de l’invité ne peut donc pas, a priori, être manipulée s’il n’a pas donné son accord. Sur les 500 000 voix enregistrées depuis 2017, personne n’est parvenu à contourner cette sécurité, selon la start-up. Alexandre de Brébisson imagine un avenir où la réputation du journaliste et de son média sera centrale. « Sur Internet, les informations deviendront si peu fiables que l’on se tournera de nouveau vers la presse traditionnelle de manière plus systématique », pense le jeune chercheur qui, par ailleurs, espère que des lois encadreront ces technologies. Il imagine, entre autres, l’équivalent d’un copyright pour la voix. On aimerait y croire.

Si 96 % des deepfakes concernent encore des montages à caractère pornographique, selon une étude menée par l’entreprise de cybersécurité Deeptrace en 2019, la vie politique est aussi concernée. Nombreux sont les pays qui pâtissent déjà de cette technologie. Ce fut le cas du Gabon, en décembre 2018. La première prise de parole captée du président Ali Bongo Ondimba après son AVC a semé le doute dans la population, plusieurs indices (les yeux immobiles, la faible fréquence des battements de paupières, etc.) laissant croire que la vidéo était un deepfake. Doutant de la bonne santé du chef de l’État, l’armée a tenté, une semaine après la diffusion de l’enregistrement, un coup d’État. Vraie ou fausse déclaration ? La possibilité du mensonge a eu des conséquences désastreuses. On peut imaginer l’impact du développement de ces technologies à l’avenir, notamment dans des pays privés de médias de confiance.

III. Une diffusion de plus en plus rapide

Selon les estimations de l’association allemande Bitkom, 1 200 milliards de photos auraient été prises dans le monde au cours de l’année 2017. Les réseaux sociaux en sont les principaux vecteurs. Plus de 100 millions de photos et de vidéos sont publiées chaque jour sur Instagram. Déjà en 2013, plus de 350 millions de photos étaient téléchargées en moyenne chaque jour sur Facebook, soit plus de 14 millions de photos par heure ou 4 000 photos par seconde. Dans ce flot gigantesque d’images, quelle part de fake news ? Et comment les images manipulées parviennent-elles à se démarquer et à capter notre attention ?

S’il est compliqué d’établir des statistiques précises, l’activité des cellules de fact-checking donne une idée de l’ampleur du phénomène. Selon Grégoire Lemarchand, à la tête du service des réseaux sociaux et du fact-checking de l’AFP, plus de 50 % des fake news identifiées et traitées chaque jour par l’agence sont des images. Le journaliste constate un besoin croissant de vérification de la part des internautes : en 2020, le site AFP Factuel a connu un indice de fréquentation quatre fois supérieur à celui de l’année précédente, avec un pic au début de l’épidémie de Covid-19. À cette occasion, nombre d’images ont été vectrices de fausses informations, comme de faux arrêtés préfectoraux ou des cartes de déconfinement prétendument fournies par le ministère de l’Intérieur. « L’image est un médium privilégié quand on a un discours complotiste à faire passer », précise le journaliste.

Si les complotistes jouent un rôle indéniable dans la création et la diffusion de fake news, ils sont loin d’être les seuls aux commandes. Mehdi Moussaïd, chercheur en sciences cognitives à l’institut Max-Planck de Berlin et spécialiste des foules, distingue trois profils principaux de créateurs de fake news. D’abord, les arnaqueurs. Ils représentent, de loin, le plus grand groupe. En créant du faux contenu viral, ils poussent les internautes à se rendre sur des sites web hébergeant de la publicité rémunérée. Leur intérêt est principalement lucratif. Pendant la campagne présidentielle américaine de 2016, des étudiants macédoniens originaires de la ville de Vélès, ont ainsi pu gagner jusqu’à 2 500 euros par jour en diffusant de fausses informations en faveur de Donald Trump. Cela conduit au deuxième profil : les fabricants de fake news qui trouvent justement en elles un intérêt politique. Ces derniers cherchent à tromper pour faire passer un message ou faciliter l’accès au pouvoir du candidat qu’ils soutiennent. Le troisième profil, beaucoup plus marginal, est celui des blagueurs : typiquement, l’adolescent cherchant à s’amuser et voulant observer comment une information qu’il a fabriquée se diffuse.

La frontière entre humour et fake news est parfois poreuse. « Les mèmes [qui se présentent souvent sous la forme de détournements humoristiques d’images] sont de grands vecteurs de fake news, particulièrement appréciés des groupuscules extrémistes, explique la journaliste Maëlle Fouquenet, ex-formatrice à l’ESJ Pro, la section de l’École supérieure de journalisme de Lille consacrée à la formation continue et au conseil auprès des médias. Ils sont faciles à manier, ont un côté rigolo, léger. Leur ambiguïté permet de faire passer un message de manière masquée, et donc plus efficace. » Parfois, l’image de départ relève simplement de la satire ou de la dérision, mais finit par être décontextualisée ou manipulée par des internautes mal intentionnés. C’est la fausse histoire d’Emmanuel Macron se désinfectant mains et avant-bras après avoir serré la main d’ouvriers. À l’origine, un article du site parodique Le Gorafi datant de 2016 et titré : « Emmanuel Macron : “Quand je serre la main d’un pauvre, je me sens sale pour la journée.” » Un an plus tard, en pleine campagne présidentielle, les images d’un reportage de France 3 vont être associées à cet article satirique. On y voit le futur président se lavant les mains avec des lingettes dans une voiture. Il s’agissait en réalité d’une séquence faisant suite à une partie de pêche en Camargue au cours de laquelle Emmanuel Macron avait attrapé une anguille à mains nues. Cet exemple d’information hybride, empreinte à la fois de satire et de fake news, « montre toute la difficulté à identifier les images manipulées sur les plateformes », commente Denis Teyssou. Du canular à la fake news, il n’y a qu’un clic.

IV. Les ingrédients de la viralité

Toute image manipulée ne se diffuse pas sur la toile de manière massive. Sera plus susceptible d’être partagée à grande échelle une image sensationnaliste, faisant état d’un sujet polarisant (comme l’immigration ou les vaccins) et dont le message est facile à comprendre. Il est également essentiel que celui-ci soit en accord avec les convictions du milieu dans lequel l’image est diffusée : une image antivaccin n’aura quasiment aucune chance de devenir virale si elle est partagée au sein d’une communauté de scientifiques.

Comme le rappelle Bruno Patino dans son ouvrage La Civilisation du poisson rouge (Grasset, 2019), les ingénieurs de Google estiment que notre capacité d’attention ne dépasse désormais plus les 9 secondes. Cet élément joue dans la diffusion des fausses informations. Notre attention étant extrêmement limitée, nous la portons vers les premières informations qui apparaissent sur nos fils d’actualité, les informations les plus populaires, les plus partagées – elles-mêmes sortant du lot grâce aux algorithmes des plateformes, gardés aussi secrets que la recette du Coca-Cola. Lorsqu’une fake news commence à être massivement partagée, l’algorithme accélère le mouvement.

« Les algorithmes mettent sous nos yeux des contenus susceptibles de nous plaire, sans biais pour le vrai ou le faux, détaille Mehdi Moussaïd. Aujourd’hui, on essaye de plus en plus de les doter d’un biais en faveur de la vraie information. » Il s’agit de suivre et d’analyser en temps réel l’évolution et la rapidité de circulation des informations, qu’il s’agisse de textes ou d’images. Récemment, les résultats des expérimentations plafonnaient à 75 % de classifications correctes, précise-t-il. Un score encore largement insuffisant pour considérer la technologie au point. Cette innovation se fonde en partie sur le travail d’une équipe de chercheurs du Massachusetts Institute of Technology (MIT) qui, en 2018, a démontré qu’en observant la manière dont une image se propageait sur la Toile, on pouvait savoir si elle était vraie ou fausse, sans même s’intéresser à son contenu. Car vraies informations et fake news ont des modes de diffusion très différents. Ces derniers prennent la forme de « cascades de propagation », c’est-à-dire d’arborescences au sein desquelles une source partage l’information en direction de plusieurs cibles, qui à leur tour la diffuse vers d’autres cibles, et ainsi de suite jusqu’au dernier maillon de la chaîne. Mehdi Moussaïd explique que « plus une cascade est profonde [nombre de partages entre la source et le dernier maillon] et sa structure verticale [partage confidentiel, d’un internaute à l’autre], plus la propagation de l’information est rapide [car guidée par l’émotion] et durable, alors plus il y a de risques qu’il s’agisse d’une fausse information ». À l’inverse, les vraies informations présentent des cascades plus petites, à la structure horizontale, et une vitesse de propagation lente et éphémère.

V. Comment l'image manipule votre cerveau

En 2015, à l’occasion du World Press Photo Contest, l’un des plus prestigieux concours de photojournalisme, vingt-deux participants se sont vus disqualifiés après la découverte par le jury de la manipulation digitale de leurs images. La polémique qui s’est ensuivie a poussé les organisateurs de la compétition à rédiger une charte éthique, stipulant que les photographes en lice se devaient de « veiller à ce que leurs photos fournissent une représentation exacte et juste de la scène dont ils ont été témoins, afin que le public ne soit pas induit en erreur ». Désormais, les photos des candidats sélectionnés dans l’avant-dernier tour du concours devront passer un test de vérification informatisée. La nécessité d’un tel processus met en évidence les difficultés auxquelles sont confrontés les organisateurs de concours pour authentifier les images. « Si les experts en photographie ne peuvent pas repérer les images manipulées, quel espoir y a-t-il pour les photographes amateurs ou autres consommateurs d’images photographiques ? » s’est interrogée Kimberley Wade, chercheuse en psychologie cognitive à l’université de Warwick, au Royaume-Uni.

Depuis vingt ans, la chercheuse observe comment les fausses images sont perçues par l’humain, et comment celles-ci affectent sa mémoire et son comportement. Son diagnostic est sans appel : confronté aux fake news, et d’autant plus lorsqu’il s’agit d’images, l’être humain se fait très facilement berner. À travers plusieurs études, son équipe a montré que notre cerveau avait une capacité très limitée à distinguer une vraie image d’une fausse. « Pire, précise-t-elle, il a une tendance naturelle à penser qu’une photo est authentique. On veut penser qu’elle l’est, on reste attaché à cette idée très forte que les photos représentent le passé. » À l’heure actuelle, peu de psychologues se sont réellement intéressés au rapport à l’image sous cet angle. « Nous ne savons presque rien pour le moment », confesse la chercheuse, qui alerte sur l’urgence de développer la recherche dans ce domaine. Confrontés à un mix de photos manipulées et authentiques, les cobayes de son étude ne sont parvenus à ranger dans la bonne catégorie que 66 % des images qu’on leur a soumises : 72 % des photos authentiques et 60 % des photos manipulées.

Et même lorsque les sujets ont correctement indiqué qu’une photo avait été manipulée, ils n’étaient pas nécessairement en mesure de localiser la manipulation dans l’image : globalement, seules 45 % des manipulations ont été localisées avec précision. Les participants se sont montrés plus aptes à détecter les changements physiquement invraisemblables – comme des incohérences géométriques ou une ombre mal placée –, que les modifications physiquement plausibles, comme un changement de coiffure.

Face aux fausses images, tout le monde semble logé à la même enseigne. « Nous n’avons observé aucune différence notable de capacités entre les hommes et les femmes, ironise la psychologue, ni entre les photographes amateurs et les non initiés. Même les personnes ayant l’habitude d’éditer elles-mêmes leurs photos ne s’en sont pas mieux sorties. » Seule légère différence : les participants qui étaient conscients, avant de participer à l’étude, que la manipulation d’images était une pratique courante, ont obtenu des résultats légèrement supérieurs. Ont-ils davantage habitué leur œil à douter ? « Difficile encore de le savoir », confesse Kimberley Wade.

Quand il s’agit de vidéos, la technologie a montré qu’à l’heure actuelle, elle ne faisait pas beaucoup mieux que l’humain. En 2020, Facebook a publié les conclusions de son Deepfake Detection Challenge dont le but était d’encourager les entreprises du numérique et les universités à créer une technologie accessible à tous pour détecter les vidéos modifiées ou générées par des outils d’intelligence artificielle dans le but d’induire en erreur les internautes. Résultat : le taux moyen de réussite des 35 000 modèles informatiques proposés par les participants n’a pas dépassé les 70 %.

Plus inquiétant encore, il est désormais avéré que des vidéos manipulées peuvent affecter les souvenirs et les croyances de ceux qui les ont vues. En 2007, des chercheurs spécialistes de la mémoire ont présenté à un groupe de cobayes une fausse image rendant compte d’une manifestation contre la guerre en Irak, qui avait eu lieu à Rome, en 2003. À la suite de cette expérience, les participants, tous âges confondus, ont fait état d’un événement plus violent qu’il ne l’avait réellement été et se sont montrés moins enclins à participer à une manifestation dans le futur. L’image manipulée avait bel et bien modifié le souvenir qu’ils avaient gardé de cet événement, et les avait encouragés à modifier leur comportement à l’avenir. C’est également la conclusion à laquelle ses recherches ont conduit Kimberley Wade. Confrontés à une fausse vidéo, certains « sont prêts à témoigner d’événements qui n’ont pas eu lieu, allant même jusqu’à donner les détails de ce qu’ils pensent avoir vu – sachant que leur parole peut avoir des conséquences sur la vie d’une autre personne – ou bien à confesser un crime qu’ils n’ont pas commis, explique la psychologue. Les conséquences judiciaires peuvent être très importantes. Ce genre d’images a récemment joué un rôle dans l’émergence de mouvements globaux comme celui des antivaccins ».

La chercheuse s’inquiète du fait que la technologie avance plus vite que la science. « Les criminels sont de plus en plus doués quand il s’agit de manipuler une image. Les experts en informatique, les spécialistes des images et nous, psychologues, essayons continuellement de rester à leur niveau. On a absolument besoin d’éduquer les gens au sujet de cette réalité. La société doit devenir bien plus sceptique à l’égard des images. »

VI. L’éducation comme seule vraie arme

Comment lutter contre les images manipulées ? Comment sauver la réalité et préserver nos démocraties ? De la même manière que les moines bouddhistes s’entraînent à développer leur empathie en méditant, Kimberley Wade est convaincue que l’on peut entraîner son esprit à se montrer plus vigilant face aux images. Sa dernière étude, en attente de validation, démontre qu’il est possible d’améliorer, dans une certaine mesure, la capacité de détection des gens simplement en les sensibilisant. Les internautes, mais aussi des professions bien spécifiques, pourraient bénéficier de formations – à commencer par les forces de l’ordre qui sont de plus en plus confrontées à des passeports falsifiés par le biais du morphing. En fusionnant leur visage avec celui de la personne dont ils ont volé les papiers, les usurpateurs d’identité parviennent de mieux en mieux à tromper les douaniers. Quant à la question des faux souvenirs induits par des images manipulées, Kimberley Wade encourage les interrogateurs, dans le cadre d’une enquête, à poser systématiquement aux témoins cette question simple : « Comment savez-vous cela ? » Au fond, il s’agit de prendre conscience que nous vivons désormais dans deux mondes bien distincts : l’un réel et l’autre digital.